Исследователи из Мичиганского университета недавно разработали двунаправленную модель, которая может предсказать, насколько можно доверять как людям, так и роботизированным агентам в ситуациях, предполагающих сотрудничество человека и робота. Эта модель, представленная в статье, опубликованной в IEEE Robotics and Automation Letters, может помочь более надежно и эффективно распределять задачи между различными агентами.

«Было проведено много исследований, направленных на то, чтобы понять, почему люди должны или не должны доверять роботам, но, к сожалению, мы знаем гораздо меньше о том, почему роботы должны или не должны доверять людям», — сказал Герберт Азеведо-Са, один из исследователей. «Однако в настоящей совместной работе доверие должно идти в обоих направлениях. Помня об этом, мы хотели создать роботов, которые могут взаимодействовать и укреплять доверие к людям или другим агентам, подобно паре сотрудников, которые сотрудничают».

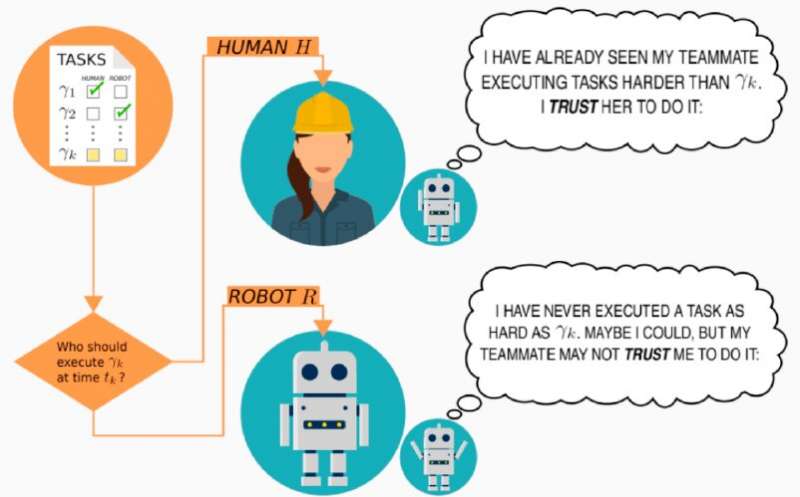

Когда люди совместно работают над определенной задачей, они обычно наблюдают за теми, с кем они сотрудничают, и пытаются лучше понять, какие задачи они могут и не могут выполнить эффективно. Узнавая друг друга и узнавая, что у других лучше всего или хуже всего, они устанавливают своего рода взаимопонимание.

«Здесь в игру вступает доверие: вы укрепляете доверие к своему коллеге при выполнении некоторых задач, но не при выполнении других задач», — пояснил Азеведо-Са. «То же самое происходит с вашим коллегой, который доверяет вам в одних задачах, но не в других».

В рамках своего исследования Азеведо-Са и его коллеги попытались воспроизвести процесс, посредством которого люди узнают, какие задачи, с которыми они сотрудничают, могут или не могут быть доверены при использовании вычислительной модели. Созданная ими модель может представлять доверие как человека, так и робота, поэтому она может делать прогнозы как о том, насколько люди ей доверяют, так и о том, насколько они могут доверять человеку для выполнения данной задачи.

Источник — aobe.